Bedrohte Freiheit

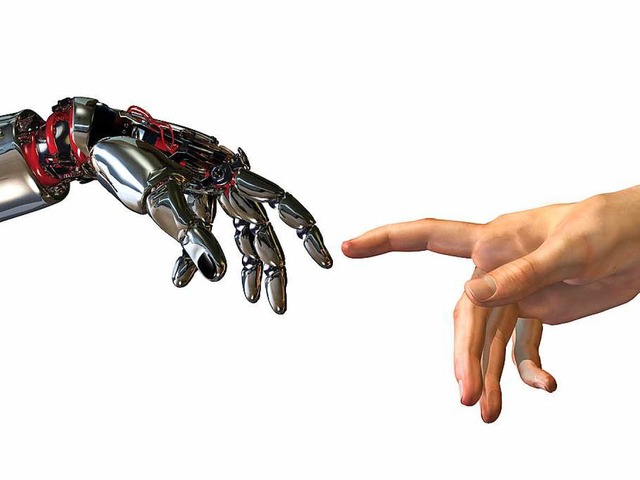

Wie weit liefern sich Menschen den Computern aus?

-

Sa, 18. Februar 2017, 00:01 Uhr

Computer & Medien

Die Automatisierung bedroht die Freiheit, sagen Wissenschaftler – und fordern einen Kodex für Maschinen. Müssen wir uns als Menschen neu definieren? Sind wir autonom oder heteronom?

Für einen gelernten Philosophen wie ihn ist diese Frage alles andere als abwegig. Denn für ihn liegt darin der Indikator, inwiefern die menschliche Freiheit mitgedacht wird. Soziale Wahrnehmung lasse sich nicht automatisieren, erst recht nicht die Freiheit zur Willkür, zu spontanen Handlungen, die eine Maschine nicht vorhersehen kann.

Die wachsende Automatisierung wird von der breiten Öffentlichkeit gerade erst wahrgenommen – und gern bewundert. Doch die ersten Wissenschaftler warnen davor, die Technik den künftigen Status quo unseres Zusammenlebens bestimmen zu lassen. "Wir haben das Recht, nicht berechenbar gemacht zu werden", sagt auch Frieder Nake, Professor für Informatik der Universität Bremen. Nake gilt als ein Pionier der Computerwissenschaft, als Mathematiker hat er Anfang der sechziger Jahre die ersten Rechner programmiert und schließlich die Informatik mit gegründet. Wohin sein Fach inzwischen geht, stimmt ihn nachdenklich. "Die Mathematik weiß, dass es harte Grenzen der Automatisierung gibt", sagt er: alles, was berechnet werden kann. Emotionen gehören nicht dazu, "eigentlich alles, was das Leben ausmacht". Wenn Menschen Maschinen bauen, die so tun, als hätten sie Gefühle, findet er das falsch.

Aus Sicht des Zukunftsforschers Mankowsky stehen wir gerade an einer entscheidenden Schwelle: Wir müssen uns als Menschen neu definieren. Sind wir autonom oder heteronom? "Wir sind handlungswirksam fremdbestimmt", sagt er, beispielsweise, wenn wir wie ferngesteuert den Anweisungen unseres Navis folgten. Die Führungskräfte bei Daimler, für die Mankowsky arbeitet, werden gefordert von ihrem Philosophen, der sie manchmal zusammentrommelt, um grundlegende Fragen zu klären: "Wer nur auf die Technologie schaut, hat nicht verstanden, wie sehr sich die Gesellschaft verändern wird."

Mit dieser Sichtweise ist Mankowsky nicht allein. "Wir brauchen einen digitalen Kodex", fordert Matthias Kammer, der Direktor des Deutschen Instituts für Vertrauen und Sicherheit im Internet (DIVSI). Von der Deutschen Post AG als unabhängige Forschungsstelle finanziert, diskutiert das Institut mit Vertretern aus Wissenschaft, Wirtschaft und Gesellschaft, inwiefern ein solcher Kodex die Lücke füllen könnte, die Gesetze in der digitalen Welt hinterlassen. Allein die Debatte um das EU-Datenschutzrecht zeige, dass Gesetze nicht alles regeln können. Kammer: "So ein Kodex fällt nicht vom Himmel, wir müssen ihn uns erarbeiten wie einen neuen Gesellschaftsvertrag." Den Vergleich mit der Französischen Revolution findet er gerechtfertigt: "In der Phase, in der wir jetzt leben, stehen viele seit 1945 stabil gewordenen Selbstverständlichkeiten in Frage."

Den Forschern geht es jedoch auf keinen Fall um Technologie-Verweigerung: Kammer kritisiert etwa, dass beim Wort "Big Data" in Deutschland vor allem an die Risiken gedacht wird, nicht aber an die darin steckenden Chancen. Mankowsky ist ebenfalls überzeugt, dass uns das Datensammeln an sich nutzt: "Wir erfahren viel über uns selbst, wir brauchen diese Daten." Nur: Vertrauen sei der falsche Begriff, kritisiert er den DIVSI-Ansatz. Es bedürfe vielmehr der Fairness und der Transparenz, damit jeder die Freiheit habe, selbst zu entscheiden, welche Daten er von sich preisgibt.

Der gegenwärtige rechtliche Datenschutz, der in solchen Fragen die "informierte Einwilligung" der Nutzer voraussetzt, sei allerdings wenig geeignet, diese Freiheit zu verteidigen, sagt der Rechtsinformatiker Nikolaus Forgó von der Universität Hannover: Das deutsche Datenschutzrecht stamme aus der Zeit der Volkszählung Anfang der 80er Jahre und habe seit Anbeginn einen zentralen Fehler – es definiere nicht in der notwendigen Genauigkeit den Begriff "personenbezogene Daten". Gehören dazu auch die Geodaten, also Angaben, wo sich eine Person aufgehalten hat oder aufhält? Und wie fein darf die Auflösung von Satellitendaten sein, bis sie personenbezogen werden?

Auch die so genannte informierte Einwilligung ist heutzutage zur Fiktion geworden: Wer alle Bedingungen lesen wollte, denen er als Internetnutzer zustimmen müsste, braucht dafür 76 Tage im Jahr. Eine Internetseite ließ kürzlich tausende Nutzer bestätigen, dass sie mit der Anmeldung ihre Seele verkauften – ein gelungener Aprilscherz, eigentlich. Nur bemerkte ihn keiner. Alle verkauften ihre Seele.

Marc Langheinrich, Professor für Informatik an der Università della Svizzera Italiana in Lugano, sieht eine große Datengläubigkeit gegeben. Dabei hätten Daten an sich keine Aussagekraft. Im Gegenteil, häufig würden aus großen Datenmengen falsche Schlüsse gezogen. Und das kann durchaus zum Nachteil derer geschehen, deren Daten gesammelt wurden – weshalb Langheinrich das Argument verheerend findet, dass sich diejenigen, die nichts zu verbergen haben, auch keine Sorgen machen müssten. Denn die Auswahl der Daten beeinflusse das Ergebnis eines Rechenprozesses ebenso wie ihre Interpretation.

Frieder Nake aus Bremen pflichtet ihm bei: "Ein Modell kann nur das ergeben, was in das Modell eingeflossen ist." Was im Umkehrschluss bedeutet: Wer ein bestimmtes Resultat erhalten möchte, kann entsprechend manipulieren, indem er die Auswahl der Daten und deren Gewichtung bestimmt. Für die Betroffenen ist das am Ende meist kaum verstehbar, da die Entscheidungen von Algorithmen häufig nicht einmal vom Entwickler selbst nachvollzogen werden können. Deshalb könne für derartige Fälle ein gesellschaftlicher Kodex durchaus nützlich sein.

Einen Kodex gibt es bereits, nämlich den "Code of Ethics" der Association for Computing Machinery. Nur ist dieser mit Grundsätzen wie "Vermeide Schaden an anderen" oder "Respektiere die Privatsphäre" sehr allgemein gehalten. "Man sagt den Entwicklern: Privatsphäre ist wichtig. Aber sie haben keine Ahnung, was das genau bedeutet", sagt Sarah Spiekermann, Professorin für Informationssysteme an der Wirtschaftsuniversität Wien. "Wenn sich Maschinen in unser Leben so einflechten, wie sie es jetzt tun, müssen wir über einen konkreteren Kodex nachdenken." Andernfalls sieht sie grundlegende menschliche Bedürfnisse in Gefahr – angefangen bei Freiheit und Gesundheit.

Spiekermann erklärt das am Beispiel eines ihr bekannten Finanzmanagers. Das EDV-System seines Unternehmens spuckt Zahlen aus, die er für falsch hält. Aber niemand im Unternehmen kann ihm sagen, wie diese zustande kommen. Ein Algorithmus hat sie errechnet, der damalige Programmierer ist nicht mehr im Haus, es gibt keine Dokumentation. Der Manager ist für Zahlen verantwortlich, deren Herkunft er nicht kennt und die er anzweifelt. Aber er ist machtlos. "Diese Situation herrscht heute in deutschen Unternehmen", sagt Spiekermann.

Deshalb hält sie auch Rückkopplungsprozesse für ein großes Thema: Wie kommunizieren wir mit den Maschinen und diese mit uns? "Feedback über das System ist ein Effekt der Kontrolle, die der Mensch über die Maschine hat", sagt Spiekermann. Auch Zukunftsforscher Mankowsky hat in seinen Experimenten nachgewiesen, dass Kommunikation ein Schlüssel dazu ist, dass die Anwesenheit intelligenter Maschinen als angenehm empfunden wird. Beispielsweise sollten autonom fahrende Autos den Menschen am Straßenrand übers Lichtsignale mitteilen, dass es sie wahrgenommen hat – und wo es hinfahren will.

Für die Software-Entwickler bedeutet das ein Umdenken. Anstatt einfach mal einen Prototyp zu programmieren und den so nach und nach weiter zu entwickeln, muss am Anfang die Frage stehen: Welche Werte sollen in das System eingearbeitet werden? "Das ist aufwendig", sagt Spiekermann, "dafür muss die Software-Entwicklung von einer Kindergartenspielwiese zu einer echten Ingenieursdisziplin werden, in der man Regeln einhält." Solche Systeme werden dann sehr viel teurer sein als heute. Aber dafür besser.

Kommentare

Liebe Leserinnen und Leser,

leider können Artikel, die älter als sechs Monate sind, nicht mehr kommentiert werden.

Die Kommentarfunktion dieses Artikels ist geschlossen.

Viele Grüße von Ihrer BZ